Enthusiasten der Augmented Realtiy (AR) aufgepasst: Apple ist der Konkurrenz in Sachen AR dank der engen Verzahnung von Hardware und iOS voraus und stellt Entwicklern mit iOS12 sein Augmented Reality Framework ARKit 2 öffentlich zur Verfügung. Mit den Verbesserungen des Frameworks verschmelzen die virtuelle und reale Welt weiter, lernen Sie die Möglichkeiten kennen.

Verbesserungen der Version 1.5

Mit dem verbesserten Kit der Version 1.5 lassen sich digitale Objekte wie virtuelle 3D-Modelle in Live-Videos der iPad- und iPhone-Kameras einfügen. Für den Anwender sieht es so aus, als wären diese dreidimensionalen Inhalte tatsächlich in der Realität vorhanden. Selbst bei Bewegungen der Kamera schwenken diese akkurat mit und die Illusion bleibt erhalten. ARKit 1.5 erkennt jetzt 2D-Bilder auf Wänden und Böden, zuvor wurden nur horizontal ausgerichtete Flächen erkannt. Bei Objekten wie Säulen funktioniert die Erkennung (noch) nicht zuverlässig. Die Erkennung vertikaler Flächen und Bilder gehört zu den neuen Features.

Verbesserungen im Überblick:

- verbesserte Oberflächenkartierung

- höhere Auflösung um bis zu 50 Prozent

- jetzt auch vertikale Oberflächenerkennung möglich (zuvor nur horizontale Erkennung)

Praktische Anwendungsbeispiele

Laut Apple eignet sich die Software zum Beispiel für eine Museums-App. Solch eine App zeigt dann einen virtuellen Kurator an, wenn der Besucher sein Smartphone auf ein Gemälde richtet. Auch kann ein Nutzer sein Smartphone auf ein Kinoplakat halten, worauf der Trailer zum Film im Poster abgespielt wird.

Einfügen Twitter-Video:

The Future of Movie Posters. ARKit 1.5 image detection and reference images. #ARKit #AugmentedReality pic.twitter.com/ruVxMCQtD3

— Mohammad Azam (@azamsharp) January 30, 2018

Ein weiteres spannendes Anwendungsgebiet sind Gesellschaftsspiele, bei denen virtuelle Figuren per Smartphone gesetzt werden können.

Voraussetzungen:

- Apple Gerät mit iOS 11.3

- Hardware setzt einen A9-Prozessor voraus (ab iPhone 6s)

- Mac mit macOS 10.13 oder höher

- Unity Version 2017.1 oder neuer

- Xcode 9.3 von Apple Developer

Verbesserungen bei ARKit 2

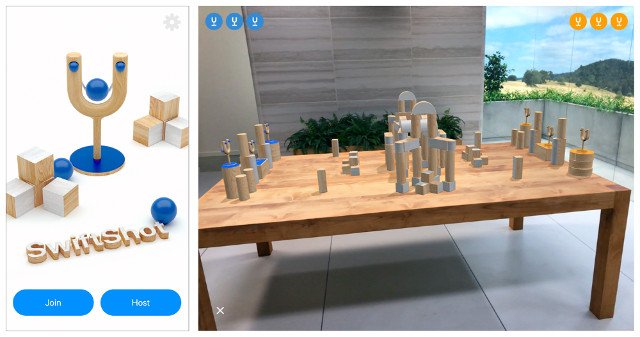

ARKit 2 wurde vergangenen Juni auf der WWDC 2018 vorgestellt. Mit der neuen Shared AR Experience lassen sich AR-Anwendungen von mehreren iOS-Geräten gleichzeitig erleben. Ein Anwender startet solch eine Shared-AR-Anwendung zuerst und andere Nutzer schalten sich einfach zum gemeinsamen Erlebnis hinzu. In der Folge sehen alle Teilnehmer zeitgleich die 3D-Inhalte. Interagiert dann ein Anwender mit der dargestellten 3D-Welt, folgt eine sofortige Anpassung der Inhalte auf den Geräten der anderen Teilnehmer. Die Funktion schafft neue Anwendungsfälle. Apple demonstriert das Potenzial mit dem Projekt Swiftshot, einer auf mehreren Geräten angezeigten 3D-Spielewelt.

Sie können den Beispielcode von Swiftshot herunterladen, das Spiel ausprobieren, den Code analysieren und damit experimentieren.

Eine weitere Verbesserung ist die Erkennung von 3D-Objekten, wie Möbeln und Spielzeugen. Die Software erkennt jetzt ebenfalls bewegte 2D-Objekte. Als Entwickler können Sie zum Beispiel Spielfiguren in eine App integrieren, die Verschmelzung mit der Realität wird dabei immer besser.

Dritthersteller haben die Möglichkeit, eigene 3D-Kreationen im USDZ-Format abzuspeichern und für AR-Anwendungen zur Verfügung zu stellen.

Voraussetzungen für ARKit 2:

Zusammenfassung

Mit dem verbesserten ARKit Framework können Entwickler komplexe Anwendungen einfacher umsetzen. Dafür sind die Voraussetzungen für ein Ökosystem mit von Drittherstellern entwickelten 3D-Objekten gegeben. Jetzt ist die Kreativität der Entwickler gefragt!

Bild von Harri Vick auf Pixabay