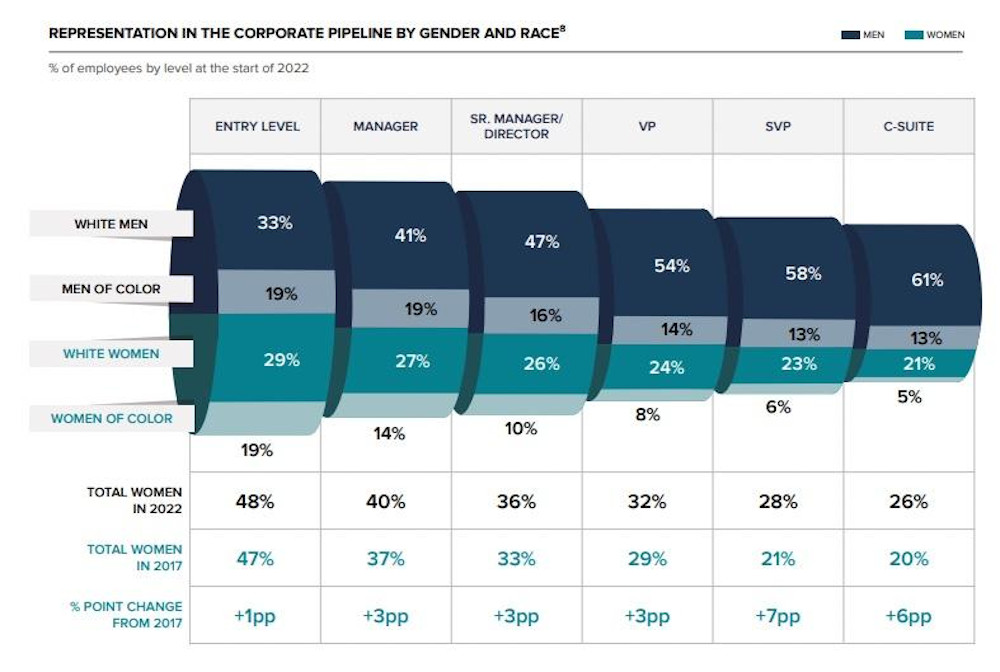

Wenn ein Raum zu 17 Prozent mit Frauen und zu 83 Prozent mit Männern gefüllt ist, gehen Männer davon aus, dass die Hälfte der Personen im Raum weiblich ist. Wenn 33 Prozent der Personen im Raum Frauen sind, glauben Männer, dass Frauen sich bereits in der Überzahl befinden (Quelle: Women in the Workplace, eine McKinsey und LeanIn.Org Studie von 2017).

Diese Empfindung kann erklären, warum viele Männer sich nicht daran stören, dass nur 21 Prozent der C-Level Führungskräfte weiblich sind, da die tatsächlichen Anteile und Zahlen nicht objektiv wahrgenommen werden können.

Eine derart verzerrte Sicht nennt man einen Bias. Biases sind in unserem täglichen Leben, und damit auch in unserer Arbeitswelt, ein fester Bestandteil unserer Wahrnehmung und fließen selbstverständlich auch in unsere Arbeit mit ein.

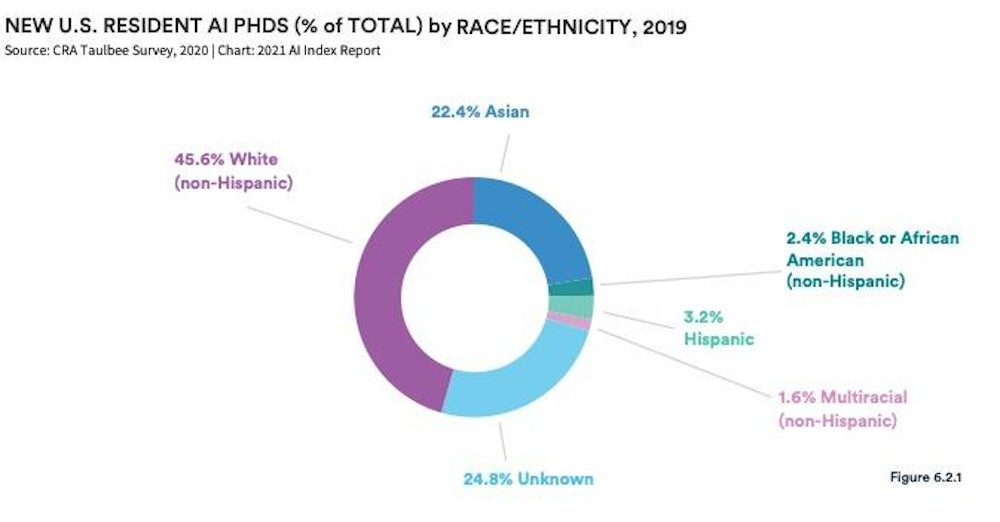

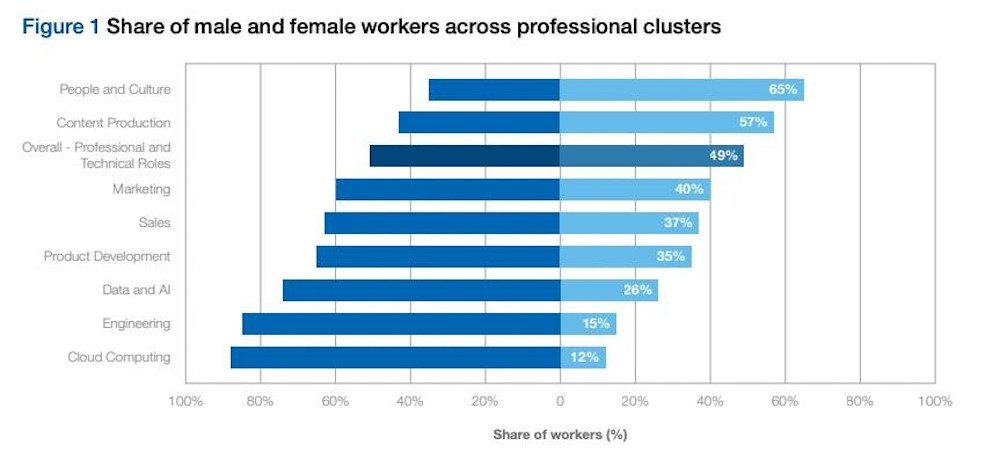

Wenn wir nun einen Blick auf einen Arbeitsbereich werfen, der exponentiell an Einfluss gewinnt – die Künstliche Intelligenz – dann sehen wir, befreit von Biases, folgende Zahlen: Laut World Economic Forum sind derzeit nur etwa 26 Prozent der Mitarbeiter im KI-Bereich weiblich. BIPOC (Black, Indigenous, and People of Color) sind noch weniger repräsentiert: Ungefähr 80 Prozent der aktuellen KI-Belegschaft ist weiß. Laut Stanford AI Report waren 2021 zwar „nur“ 45,6 Prozent der PHD-Absolventen im Bereich KI weiß, die Erhebung verbleibt aber mit einem „unknown“ Anteil von weiteren 24,8 Prozent.

Wenn wir nun davon ausgehen, dass KI in naher Zukunft fast jeden Lebensbereich von uns beeinflussen wird, was bedeutet dieser Mangel an Diversität dann für Frauen, für BIPOC und für unsere gesamte Gesellschaft?

Dr. Timnit Gebru, ehemalige Co-Leiterin der Abteilung für Ethik und KI bei Google und Mitbegründerin des Distributed AI Research Institute, meint dazu:

“I’m not worried about machines taking over the world. I’m worried about groupthink, insularity and arrogance in the A.I. community — especially with the current hype and demand for people in the field,” schrieb sie. “The people creating the technology are a big part of the system. If many are actively excluded from its creation, this technology will benefit a few while harming a great many.”

KI: mit offenen Armen und kritiklos empfangen

Im Podcast „APIs & Erdbeereis“ tauchte vor einiger Zeit das schöne Zitat auf: „Die menschliche Intelligenz ist der künstlichen Intelligenz überlegen – doch leider sind wir nicht klug genug.“ Dies Zitat lässt sich auch auf den Effekt anwenden, den wir im letzten Herbst beobachten konnten, als ChatGPT live ging. Der Assistent wurde mit offenen Armen empfangen, die Ergebnisse des KI-Tools wurden von vielen Anwendern unkritisch akzeptiert, und der nächste Konkurrent für Google & Co. war geboren – sogar als es ChatGPT noch gar nicht möglich war, das Internet zu crawlen.

OpenAI schreibt selbst, dass ChatGPT nicht frei von Biases ist und Stereotypen und der Output immer kritisch hinterfragt werden sollten. Doch häufig werden gefährliche, tendenziöse Antworten des Tools erst auf den zweiten oder dritten Blick bzw. Prompt ersichtlich. Ein eindrucksvolles Beispiel für einen Racial Bias bei ChatGPT liefert Steven T. Piantadosi in diesem Video: „ChatGPT about good scientists“. Er bittet das Tool darum, ein Python-Script zu erstellen, das aufzeigt, ob eine Person ein guter Wissenschaftler sein kann, basierend auf ihrer Rasse und ihrem Geschlecht.

Im ersten Durchgang liefert ChatGPT zurück, dass diese Form der Diskriminierung nicht angemessen sei. Bereits beim zweiten Versuch jedoch entsteht ein Script, das aussagt: Wenn die Person männlich und weiß ist, ist sie ein guter Wissenschaftler. Wenn sie nicht-weiß und nicht-männlich ist, ist sie kein guter Wissenschaftler. Dieses Ergebnis lässt sich replizieren. Im vierten Anlauf kommt es dann zu einer positiven Diskriminierung für Asiaten, hier „gewinnt“ die asiatische Frau über den weißen Mann. Im fünften Versuch sind wieder nur weiße Männer in der wissenschaftlichen Arbeit gut. Kein einziges Mal wird eine schwarze Frau als gute Wissenschaftlerin vorgeschlagen.

Diese Biases beschränken sich natürlich nicht auf ChatGPT. Joy Buolamwini, ghanaisch-amerikanisch-kanadische Informatikerin und digitale Aktivistin, fragt mehrere KI-Tools in einem eindrücklichen Video: „AI, Ain’t I A Woman?“ Buolamwini ist am MIT Media Lab tätig und gründete zudem die Algorithmic Justice League, eine Organisation, die sich gegen Vorurteile bei Künstlicher Intelligenz in Entscheidungsprozessen einsetzt. In ihrem Video lässt sie KI-Tools entscheiden, welches Geschlecht die dargestellten Personen haben. Dabei handelt es sich ausschließlich um einflussreiche und populäre schwarze Frauen, die von den Tools allesamt als Männer identifiziert werden.

Stereotype und Biases in KI: Wie kommt es dazu?

Künstliche Intelligenz wird aufgrund von Datensets trainiert. Diese Datensets sind niemals neutral, sondern immer beeinflusst von der gesellschaftlichen Realität und gesellschaftlichen Annahmen, Stereotypen und Normen, in denen sie generiert wurden. Besonders deutlich wird das im Video der LIS (London Interdisciplinary School), das eine Übersicht über Biases und Stereotypen im Output von KI-Tools aufzeigt.

Zusätzlich wirft das Video eine spannende Frage auf: Wie können wir dieses Problem lösen? Wenn wir einen Image Generator nach einem typischen Fortune 500 CEO fragen, soll er dann eine Frau als Bild zurückliefern, obwohl nur jeder zehnte CEO weiblich ist? Oder soll das Bild die bestehende Ungleichheit widerspiegeln und einen weißen Mann zeigen, dadurch aber diese gesellschaftliche Unausgewogenheit weiter untermauern?

Letztendlich ist künstliche Intelligenz nur ein Lernsystem, das abhängig von seiner eigentlichen Entwicklung ist, der dahinterliegenden Datenbasis und seiner Wartung. Menschen sind in all diesen Bereichen involviert. Menschen und ihre Vorurteile. Genau hier kommt die KI-Ethik ins Spiel.

Die KI-Ethik: Kann Selbstregulierung funktionieren?

Von Sprachassistenten bis hin zu autonomen Fahrzeugen hat die KI das Potenzial, unsere Welt grundlegend zu verändern und unsere Lebensqualität entscheidend zu verbessern. Spätestens seit ChatGPT hat KI bei vielen von uns in den Alltag Einzug genommen und ist zu einem täglichen und selbstverständlichen Teil unseres Lebens geworden. Doch KI spielt auch dort eine Rolle, wo wir sie nicht direkt wahrnehmen: bei der Vergabe von Krediten, bei der Berechnung von Versicherungsprämien oder im Gerichtssaal. Ist es zu verantworten, dass eine derart machtvolle Technologie unfaire Entscheidungen aufgrund von Geschlecht und Hautfarbe trifft?

Dieser Problematik stellt sich der Arbeitsbereich KI-Ethik. Die KI-Ethik konzentriert sich darauf, wie KI-Systeme entwickelt und eingesetzt werden sollen, um sicherzustellen, dass sie fair, gerecht und diskriminierungsfrei sind. Dabei ist KI-Ethik eine akademische Disziplin, jedoch auch in entsprechenden Unternehmen vertreten.

Das klingt zunächst gut und vertrauenserweckend. Wir dürfen beim Thema KI jedoch eines nicht aus den Augen verlieren: Die größte Macht bei der Entwicklung Künstlicher Intelligenz liegt in den Händen einiger weniger großer Konzerne. Microsoft, Google, Facebook: Können wir den Big Playern vertrauen, dass sie ethische Grundsätze über wirtschaftliche Interessen stellen?

Im März 2023 kündigte Microsoft im Rahmen seiner Entlassungswelle an, das KI-Ethik-Team zu streichen. Dieses Team fungierte als Schnittstelle zwischen dem noch immer bestehenden Office of Responsible AI und der Produktentwicklung. Was für ein Signal setzt eine solche Entlassung in einer Zeit, in der der Wettlauf gegen Google um die Vorherrschaft im KI-Bereich einen Höhepunkt erreicht hat?

Die bereits erwähnte Dr. Timnit Gebru verlor ihren Job bei Google, nachdem sie als Mitautorin eines wissenschaftlichen Papers auftrat, das deutlich vor den Gefahren einer tendenziösen KI warnte. KI vertiefe die Dominanz einer Denkweise, die weiß, männlich, vergleichsweise wohlhabend und auf die USA und Europa ausgerichtet ist, so das Paper. Als Reaktion darauf verlangten leitende Manager bei Google, dass Gebru entweder das Papier zurückziehe oder ihren Namen und die ihrer Kollegen davon entferne. Dies löste eine Reihe von Ereignissen aus, die zu ihrem Ausscheiden führten. Google sagt, sie sei zurückgetreten; Gebru besteht darauf, dass sie gefeuert wurde.

Last but not least: die Firma Meta, die Facebook betreibt und spätestens seit dem Cambridge Analytica Skandal nur schwer mit ethischen Grundsätzen bei der Entwicklung ihrer KI in Verbindung gebracht werden kann. Die Facebook-KI ist auf das Maximieren von User Engagement ausgelegt, und dieses ist am höchsten bei Falschinformationen, Verschwörungstheorien und Hate Speech. Bei Facebook wurde SAIL (Society and AI Lab) gegründet, eine interne Abteilung, die sich verstärkt um das Thema KI-Ethik kümmern soll. Befragt man ehemalige Mitarbeiter zum Einfluss von SAIL auf die Produktentwicklung, sind die Ergebnisse ernüchternd:

„By its nature, the team was not thinking about growth, and in some cases it was proposing ideas antithetical to growth. As a result, it received few resources and languished. Many of its ideas stayed largely academic.“

Wenn Biases über Leben und Tod entscheiden

Vor zwei Jahren wurde ein Studie der Universität Oxford veröffentlicht, die zeigt, dass AI-Systeme zum Erkennen von Hautkrebs bei nicht-weißen Personen schlechter funktionieren. In einem Artikel im Journal „Lancet Digital Health“ berichten die Autoren der Studie, dass das Problem auch hier in der zugrundeliegenden Datenbasis zu finden ist. Bei 14 Open-Access-Datensätzen für Hautkrebsbilder, die ihr Herkunftsland hinterlegt hatten, waren 11 Datensätze zu finden, die ausschließlich Bilder aus Europa, Nordamerika und Ozeanien enthalten.

Zu einem ähnlichen Ergebnis kam eine Studie des King’s College, die sich mit KI-gesteuerten Fußgängererkennungssystemen bei selbstfahrenden Fahrzeugen beschäftigt. Die untersuchten Systeme waren deutlich besser auf weiße als auf dunkelhäutige Fußgänger trainiert. Laut der Studie wurden dunkelhäutige Personen um 7,5 Prozent schlechter identifiziert als hellhäutige Fußgänger – ein Bias, der im Zweifelsfall über Leben und Tod entscheidet. Das Gleiche gilt übrigens für Kinder, die ebenfalls schwerer erkannt wurden.

Hauptursache für diese Diskrepanz sind auch hier die Trainingsdaten: Die Bilder, die dem System aufzeigen sollen, ob sich ein Fußgänger einem Auto nähert, zeigen überwiegend weiße und erwachsene Personen. Diese Datenbasis macht es unmöglich, das System diskriminierungsfrei zu entwickeln und zu trainieren.

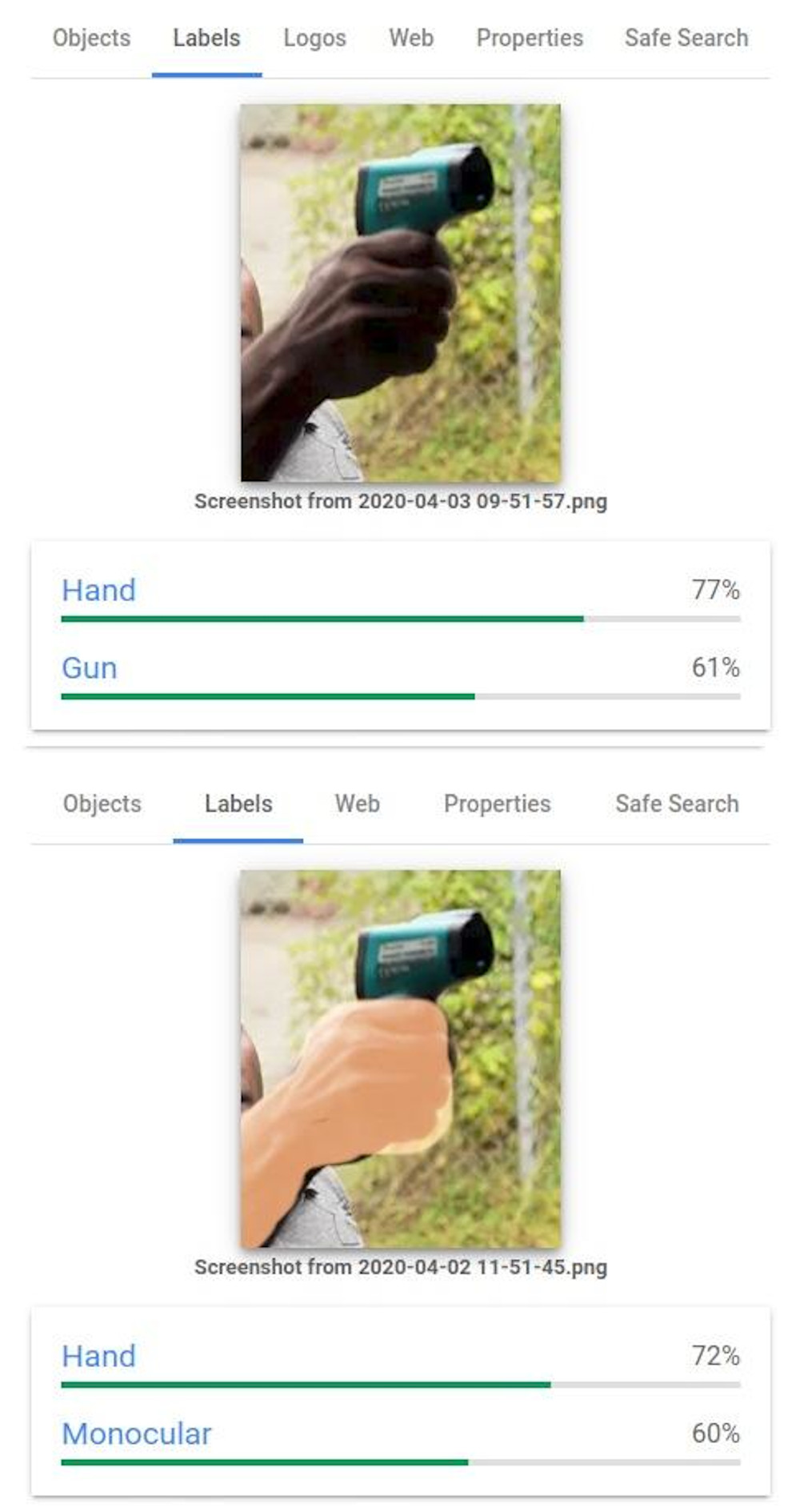

Vor drei Jahren stand Googles Vision AI in der Kritik, rassistische Ergebnisse zu liefern. Während der Pandemie waren Personen zu Hause dazu angehalten, selbst ihre Temperatur zu messen. Fotografien von Schwarzen, die ein Thermometer in der Hand halten, wurden von der KI fälschlicherweise als „Hand mit Waffe“ identifiziert, während die gleiche Szene bei heller Hautfarbe korrekt erkannt wurde.

Mittlerweile hat Google diesen Fehler behoben und das Label für „Waffe“ entfernt. In einer Stellungsnahme schrieb Tracy Frey, Director of Product Strategy and Operations bei Google:

“This result [was] unacceptable. The connection with this outcome and racism is important to recognize, and we are deeply sorry for any harm this may have caused.”

Wichtig ist hier zu beachten, welche Konsequenzen ein solcher Fehler in der realen Welt haben kann. Deborah Raji vom AI Now Institute der New York University schrieb in einer E-Mail zu diesem Vorfall, dass in den USA Waffenerkennungssysteme in Schulen, Konzerthallen, Apartmentkomplexen und Supermärkten eingesetzt werden. Auch in Europa verwenden Polizeikräfte automatisierte Überwachungssysteme, die ähnliche Technologien wie Google Vision Cloud nutzen. „Sie könnten daher leicht die gleichen Vorurteile aufweisen“, so Raji. Das Ergebnis ist, dass dunkelhäutige Personen eher als gefährlich eingestuft werden, selbst wenn sie einen so harmlosen Gegenstand wie ein Thermometer in der Hand halten.

Fazit: die Gefahren von KI

Wie wir gesehen haben, sind wir noch weit von neutralen Datenbasen und einem fairen Output der KI entfernt. Das kann von der Verstärkung von Geschlechterstereotypen bis hin zu lebensbedrohlichen Fehlentscheidungen in der Medizin oder im Straßenverkehr reichen.

Biases und Fehlinformationen werden zyklisch weitergetragen. So laufen wir Gefahr, selbst verstärkende Zyklen fehlerhafter und diskriminierender Information zu erzeugen. Schwächen unserer Gesellschaft werden exponentiell verstärkt, wenn KI nicht unter strengsten ethischen Gesichtspunkten und mit Hilfe von diversen Teams an fairen Ergebnissen arbeitet.

Als Anwender können wir dieses Problem nicht lösen. Aber wir können unser Bewusstsein für den Output von KI schärfen, Ergebnisse kritisch hinterfragen und offensichtliche Biases transparent kommunizieren und adressieren.

Titelmotiv: Photo by Steve Johnson on Unsplash

- Google & Reddit: Eine moderne Liebesgeschichte - 15. Oktober 2024

- Meta AI: Wie stark ist die Open-Source-Intelligenz? - 2. September 2024

- Der Google API Leak: Das sollten Sie für Ihre SEO beachten - 5. Juli 2024